Después de darnos cuenta que existen unos cuantos métodos para desindexar urls, no tan conocidos o habituales, hemos decidido hacer un pequeño test probando todos los métodos que hemos recopilado.

Inicialmente este post cubría 6 casuísticas distintas, a través de 6 urls distintas (urls antiguas, para ser exactos).

Casuísticas para desindexar urls

Después de una interesantísima conversación con mi amigo y gran SEO David Esteve, hemos pensado en hacer este test mucho más completo, cubriendo 14 casuísticas diferentes.

Una vez tengamos los resultados de cada una, editaremos este post contando lo que hemos visto y compartiendo los hallazagos, con los logs en la mano y el seguimiento de desindexación de cada caso.

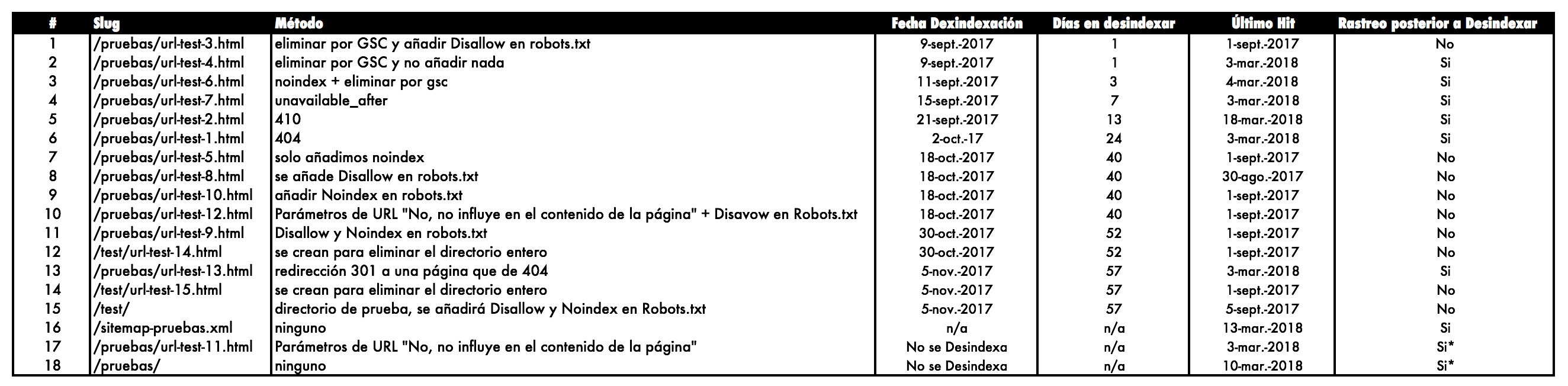

Las casuísticas analizadas son:

Los objetivos que perseguimos con estos test:

Metodología del test para desindexar urls

Replanteando los pasos que estamos siguiendo para el análisis son:

- Hemos creado una url para cada test, sin css, enlaces entrantes, todas parten en mismas condiciones.

- Cada url tiene un title, una description, un h1 y 3 párrafos de texto.

- Añadiremos un sitemap específico de estas urls en GSC y referenciado en robots.txt

- Se añadirá también un link en el footer o menú, apuntando a los 2 directorios creados, «pruebas» y «test».

- Se solicitará la indexación de todas las urls el día 30 de agosto a través de Google Search Console.

- Una vez indexadas, meteremos a cada una, el método de desindexación indicado en la tabla

- Revisaremos los logs a diario para ver el comportamiento que ha seguido google respecto a estas urls.

- Revisaremos la indexación de las 15 urls con UrlProfiler, dos veces al día.

- Según se vayan produciendo resultados, iremos actualizando el post para compartir los resultados.

Responder 404 o 410

A pesar de que el contenido pueda seguir siendo rastreado cuando una url es eliminada, el 410 puede ser un método que se encuadra para casos de contenidos que no van a volver a estar disponibles.

Por ejemplo, en ciclos de urls con rotación o donde existan señales positivas SEO, como rankings, tráfico orgánico, backlinks…. este no debería ser el método elegido a priori, sino considerar reciclar esas urls redirigiendo, actualizando su contenido, etc.

Con el test, vamos a intentar ver las diferencias que existen entre responder 404 0 410 y cómo afecta en la desindexación de contenidos.

No obstante, la naturaleza del código de respuesta 410 le otorga el carácter de «permanente», por lo que a priori, a falta de tener los resultados del test, debería ser el que eliminase los contenidos del index más rápido.

Los test 1 y 2 nos sacarán de dudas.

Eliminar en Google Search Console

Podemos eliminar la url a través de Google Search Console, vamos a «Índice de Google» > «Eliminación de url»

Nos va a permitir elegir la opción que más se adecúe a lo que queremos hacer:

- Ocultar temporalmente la url de los resultados y del caché

Nos especifica que tendrá efecto sobre las variaciones de la url

- Ocultar temporalmente la url del caché

Esta opción no la elimina de los resultados.

- Ocultar temporalmente la url

Aquí nos especifica que si queremos que sea de forma permanente usemos uno de los métodos recomendados:

– Hacerla privada con un login

– Eliminarla (404 0 410)

– Meta robots Noindex y dejarla abierta a rastreo

Con esta opción vamos a lanzar el test 4, por lo que la instrucción durará 90 días y posteriormente observaremos qué ocurre: si se indexa de nuevo o no.

La variante a este va a ser el test 3, ya que una vez usemos «Eliminar URL» en Google Search Console, posteriormente vamos a bloquearla en robots.txt, para confirmar si se vuelve a indexar o no, dado que Google supuestamente no va a poder entrar a ver el contenido de la etiqueta meta robots, la teoría dice que no debería indexarla pasados 90 días, veremos qué resultados obtenemos…

La funcionalidad de Google Search Console de «Eliminar URL», es bastante efectiva y rápida, pero al igual que «Explorar como Google», la petición se hace una a una.

[En los comentarios, varias personas recomiendan esta extensión https://github.com/noitcudni/google-webmaster-tools-bulk-url-removal, en mi experiencia con este tipo de plugins, no me ha resuelto la necesidad de desindexar grandes listados de urls, por lo que para casos concretos de listados acotados, puede ser una buena solución, ¡como siempre, depende!]

Añadir Meta Robots Noindex

El método de desindexación más limpio cuando el contenido va a seguir estando activo respondiendo 200 OK es añadir la etiqueta meta robots noindex, así como no bloquear la url o directorio a través de robots.txt, así nos aseguramos que la nueva etiqueta es vista. Al menos esto es lo recomendado en la teoría por Google 🙂

Para usar este método, añadimos la etiqueta dentro del <head> de la url en cuestión:

<meta name=»robots» content=»noindex» />

Si nos enfrentamos a desindexar grandes volúmenes de urls con este método, la opción a utilizar puede ser buscar modos de agilizar el rastreo de esas urls, es decir, forzar a Google a que visite esas páginas, una idea puede ser:

- Creando un sitemap específico para que las rastree y vea el «noindex»

- Creando un mapa web con las urls implicadas.

- Enlazando el mapa web en algún lugar muy rastreado.

Con el test 5, veremos cuánto tiempo tarda en desindexar la url, tan solo con la etiqueta meta noindex.

Con el test 6, además de añadir el noindex, usaremos la opción de «Eliminar URL», para confirmar si pasados los 90 días, permanece desindexada o no.

Añadir meta robots unavailable_after

Desde 2007 lleva esta opción que Google explicaba en un post de su blog y que Lino ya había publicado sus pruebas entonces.

La forma de la etiqueta es así:

<META NAME=»GOOGLEBOT» CONTENT=»unavailable_after: 25-Aug-2007 15:00:00 EST»>

De este modo «solicitamos» a Google que desindexe el contenido a partir de esa fecha, el propio artículo dice que puede tomar un día o más en procesar la petición.

Este método (y los meta robots del punto anterior) también se pueden usar a través de Cabeceras HTTP, podéis ver la documentación de Google al respecto: https://developers.google.com/webmasters/control-crawl-index/docs/robots_meta_tag?hl=es-419

Sin duda esta opción puede ser muy útil para ciclos de urls que sabemos que caducan, pero que por otro motivos, no podemos hacer que expiren con 410, como una pila de urls de productos que rompen stock.

Herramientas como Screaming Frog, siguen el contenido de este tag, pero no en el formato de ejemplo usado sino en la directiva general, por ejemplo esta sintaxis si es detectada por «la rana»:

<meta name=»robots» content=»unavailable_after: 25 Jun 2010 15:00:00 PST» />

Esta sintaxis NO la detecta:

<meta name=»googlebot» content=»unavailable_after: 27-Aug-2017 23:45:00 GMT»>

El test 7, pretende confirmar si esta etiqueta funciona para desindexar selectivamente a partir de una fecha concreta y pretendemos hacer seguimiento a qué ocurre después, a nivel de rastreo e indexación.

Añadir Disallow en Robots.txt

Aunque técnicamente no es un método de desindexación, sino de persuadir a los robots de rastrear determinados contenidos, en ocasiones se usa como forma de depreciar contenidos de un site y haciendo disminuir su rastreo, Google los va priorizando cada vez menos.

Como concepto de SEO básico, conviene recordar el funcionamiento y uso de este fichero:

«(…) Si necesitas asegurarte de que no se indexa una URL, utiliza la metaetiqueta robots o la cabecera HTTP «X-Robots-Tag»

Más info en: https://support.google.com/webmasters/answer/7424835?hl=es&ref_topic=6061961 y https://support.google.com/webmasters/answer/6062608?hl=es

Siguiendo con el test 8, se observará en los logs si deja de ser rastreada y con el paso del tiempo, si se desindexa o no, además, teóricamente debería aparecer en el snippet de Google el típico «La description de este sitio no se muestra…..»

Añadir Noindex en Robots.txt

Ahora también se puede indicar la instrucción «noindex» dentro del fichero robots.txt, con líneas tal que:

Disallow: /example-page-1/

Disallow: /example-page-2/

Noindex: /example-page-1/

Noindex: /example-page-2/

La utilidad de este marcado, tal y como indican en este post de DeepCrawl es poder indicar directivas por patrones de urls, de forma muy limpia y rápida.

Siguiendo con el test 9, queremos comprobar si se desindexa con este método, pues parece que no es una etiqueta «oficial» para Google, pero diversos test, parece que funciona perfectamente.

Con el test 10, vamos a omitir la instrucción Disallow y solo usa Noindex, dentro del fichero robots.txt, para confirmar si es obligatorio usar ambas líneas o no. Reflexionando sobre una página que quisiéramos desindexar con el tag «noindex» en el <head> del html, el propio Google nos pide que no bloqueemos por robots.txt, sin embargo este método «diferente», parece que «exige» ambas líneas, que supuestamente bloquea rastreo e indexación.

Veremos qué sale 🙂

Gestión de Parámetros en Google Search Console

Otro tema a chequear es si podemos influir en la desindexación de contenidos, configurando los parámetros de Google Search Console, indicándole esta opción:

De igual modo que comentábamos sobre añadir un «disallow» y google irá dejando de rastrear y dar importancia a esos contenidos, y quizás con el tiempo, desindexar, ponemos el test 11 en marcha para confirmar qué pasa con estas urls.

Para rizar un poco más el rizo, a esta opción, le metemos una variante en el test 12, para chequear si el uso de parámetros puede ser compatible con el uso de «Disallow» dentro del fichero robots.txt, supuestamente la gestión de parámetros le dice «no rastrees esto»,¿bloqueará el acceso a Google y dejará de tener efecto? ¡Todo incógnitas!

Redirección 301 a una url 404

Otro escenario curioso que queremos probar es ver qué pasa con una redirección que apunta a un 404, porque si se desindexa antes que otros métodos que hemos comentado, puede ser una gran alternativa para desindexar contenidos.

El test 13 va a comprobar si realmente se desindexa o no y cuánto tiempo tarda en hacerlo. También chequearemos cuándo deja de rastrear el 404, ya que estamos 😀

Desindexar un directorio entero

Para terminar, hemos pensado en confirmar si desindexando un directorio entero, desindexaríamos las urls que están dentro de dicho directorio.

Para este test 14, añadiremos Disallow y Noindex en el robots.txt y si conseguimos desindexar las urls que cuelgan de ese path, habremos triunfado y nos quitaremos muchos problemas de golpe 😀

Resultados del Experimento

- Se solicitó la indexación el mismo 30 de agosto de 2017

- Se solicitó la desindexación a los 8 días, el 8 de septiembre de 2017, cada url con su método.

- Hemos analizado logs hasta el mismo 18 de marzo de 2018.

Aquí os mostramos el orden en el que se han desindexado y algunos datos más, basándonos en los logs del servidor

El ranking de más rastreadas, quedaría así:

Reflexión

- Eliminar por Google Search Console, es lo más rápido, pero si no se añade otro método, a los 3 meses vuelve a indexar.

- Me sorprende la etiqueta «unavailable_after» más que nada porque nos equivocamos con el año y aún así, la ha desindexado (pusimos «unavailable_after: 22-Sep-2007 15:00:00 EST» en vez de 2017).

- 410 se fue antes que la de 404

- Noindex y Disallow, han tardado lo mismo en desindexar

- Noindex en robots.txt, a pesar de que Google confirmó que no era una directiva de aplicación, si acabó desindexada, aquí más gente que hizo test hace años, sin duda, habría que poner foco en este, para sacar datos más concluyentes

- Para desindexar un directorio entero, llama la atención que se desindexe primero una url y luego la otra y el propio directorio (5 días de diferencia)

- A día de hoy la 3, 5 y 8, están indexadas pero aparecen como resultados omitidos de Google

- A día de hoy, la 4 se ha vuelto a indexar, pues la opción eliminar de Google Search Console, si no va a acompañada de un método de desindexación, puede volver a indexarse (como efectivamente ha ocurrido)

Hoy más que nunca, esperamos vuestros comentarios para ver si era lo que esperabais, si habéis vivido situaciones diferentes y poder generar debate al respecto 🙂

Esperamos montar más experimentos en breve, stay tuned!

Hola.

Pues muy interesante estos texts. Precisamente he estado últimamente haciendo algunas pruebas para desindexar, ya que GSC no desindexsaba las url que le indicaba y tampoco lo conseguí con Disallow en robots. Finamente opté por un 404 y estoy observando cuanto tiempo tardará Google en desindexarlas.

Ya estoy deseando conocer los resultados…

Saludos

Los tienes al final de post, a ver si te parece útil 🙂

¿Habemus resultados!

Hola Juan!

Sip, habemus resultados, los puedes encontrar al final del post 😉

Gracias!

Muy interesante , estaré muy atenta a los resultados. Veremos a ver si coinciden con mis experimentos. Gracias MJ Cachón

Hola Sara!

Ya tienes los resultados del test publicados, al final del post 😉

Gracias!

Al final ¿cuales han sido los resultados?

Estamos recopilando la info para publicarlos 🙂

Hola Juan Carlos!

Hemos publicado ya los resultados del test, los tienes al final del post 😉

Gracias!

Hola, me parece un test genial! ¿Tenemos resultados ya?

En diciembre recopilaremos los logs y documentaremos cuándo se ha desindexado cada cosa…. en breve publicamos 😉

Hola Varian!

Tenemos los resultados del test publicados, al final del post 😉

Gracias!

Hola.

Sigo atento a la publicación de resultados….

Hola Luis!

Ya tienes los resultados del test publicados, al final del post 😉

Gracias!

Hola ¿cuándo tendréis los resultados? Me gustaría saber el método más efectivo para desindexar del todo y que no vuelva a aparecer. Gracias

Hola Mercedes!

Ya están los resultados publicados. Los tienes al final del post 😉

Gracias por unirte!

Hola!

Sólo daos la enhorabuena por el post. ¡Me ha encantado!

Un experimento genial y muy bien explicado.

Personalmente yo aplicaría alguno de los métodos en función de cómo sea la página que quieres desindexar, pero para eso lo habéis explicado así, para que cada uno vea los resultado y aplique según crea.

Enhorabuena de verdad.

Un saludo!

Gracias por el estudio, la verdad que se deberían hacer más pero la falta de tiempo siempre aprieta.